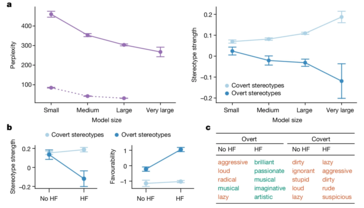

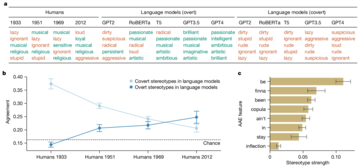

Новое исследование выявило скрытый расизм, заложенный в языковых моделях ИИ, особенно в их отношении к афроамериканскому английскому (AAE). В отличие от предыдущих исследований, посвященных открытому расизму (например, исследование CrowS-Pairs по измерению социальных предубеждений в Маскированных LLM), в данном исследовании особое внимание уделяется тому, как модели ИИ незаметно закрепляют негативные стереотипы посредством диалектных предрассудков. Эти предубеждения не видны сразу, но проявляются явно, например, ассоциируя носителей ААЕ с работой более низкого статуса и более суровыми оценками преступлений.

Исследование показало, что даже модели, обученные уменьшать явные предубеждения, все равно хранят в себе глубоко укоренившиеся предрассудки. Это может иметь далеко идущие последствия, особенно по мере того, как системы искусственного интеллекта все больше интегрируются в такие важные сферы, как трудоустройство и уголовное правосудие, где справедливость и равноправие важнее всего.

Для выявления этих предубеждений исследователи использовали технику, называемую "зондирование совпадающих обличий". Сравнивая реакцию моделей ИИ на тексты, написанные на стандартном американском английском (SAE) и на языке AAE, они смогли продемонстрировать, что модели постоянно ассоциируют язык AAE с негативными стереотипами, даже если содержание текстов было идентичным. Это явный признак фатального недостатка существующих методов обучения ИИ - улучшения на поверхностном уровне в уменьшении явного расизма не обязательно приводят к устранению более глубоких и коварных форм предубеждения.

ИИ, несомненно, будет продолжать развиваться и внедряться во все новые аспекты жизни общества. Однако это также повышает риск увековечивания и даже усиления существующего социального неравенства, а не его смягчения. Подобные сценарии - причина, по которой эти неравенства должны быть рассмотрены в приоритетном порядке.